Wenn ein Hersteller eine Genauigkeit von 98% für seinen Sensor angibt, entspricht dieser Wert fast immer Messungen, die unter optimalen Testbedingungen durchgeführt wurden: jeweils nur ein Benutzer, konstante Durchgangsgeschwindigkeit, ideale Installationshöhe, ideale Installationshöhe, neutrale Wetterbedingungen. Dies sind Bedingungen, die im realen Einsatz selten anzutreffen sind, insbesondere auf stark frequentierten Strecken oder in natürlichen Umgebungen.

Die Zählergenauigkeit ist kein fester Wert. Es handelt sich um einen Leistungsbereich, der sich je nach Umgebung, Einsatzkontext und Qualität der Installation weiterentwickelt. Es ist wichtig, diese Nuance zu verstehen, um eine Lösung richtig zu beurteilen, Angebote zu vergleichen und realistische Erwartungen an Ihr Projekt zur Anwesenheitsmessung zu stellen.

Die eigentliche Frage lautet nicht: „Erreicht dieser Sensor eine Genauigkeit von 97 oder 98%?“ sondern: „Unter welchen Bedingungen ist diese Präzision garantiert und wie verhält sich der Sensor, wenn diese Bedingungen nicht erfüllt sind? “

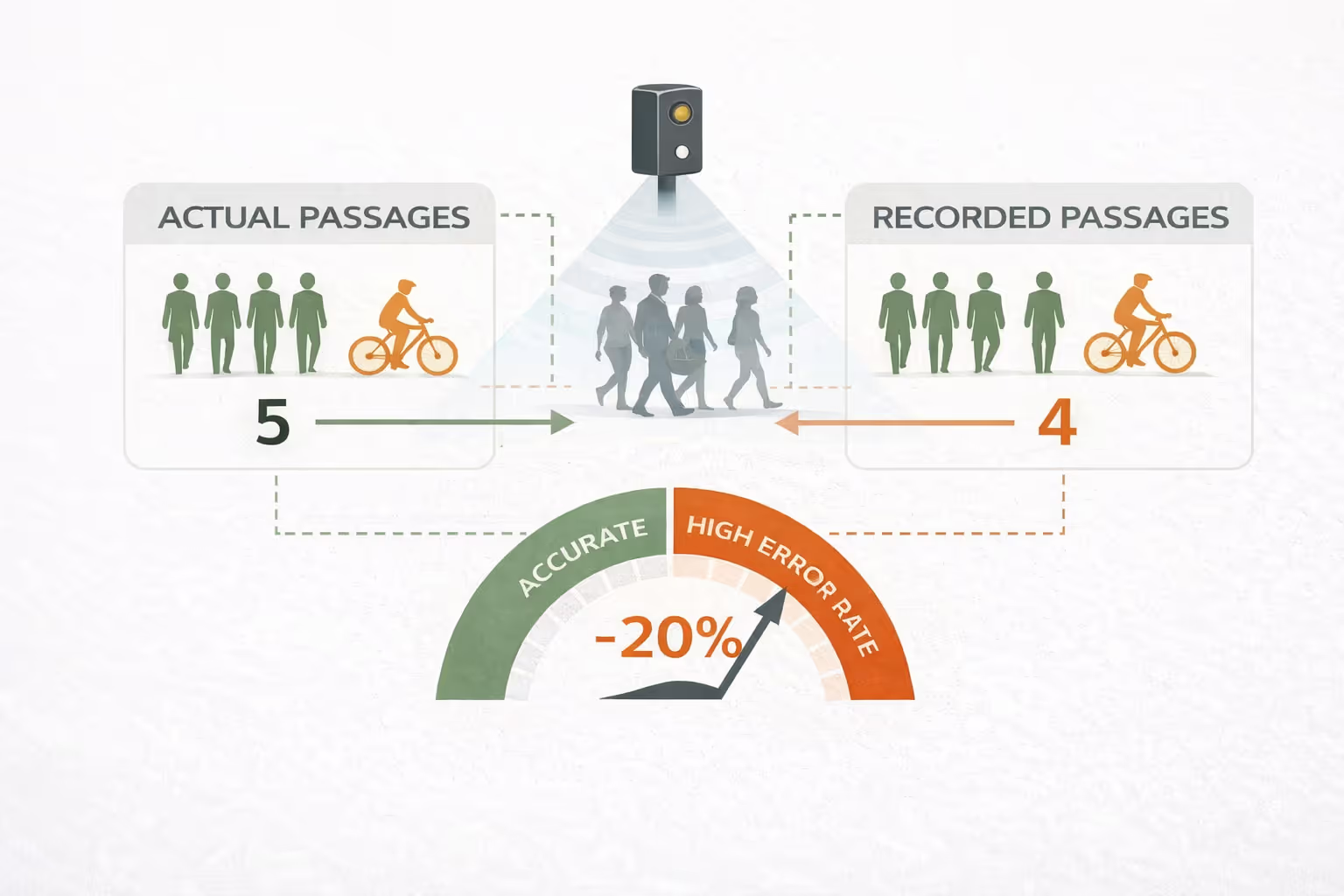

Es ist der erste Degradationsfaktor für fast alle Zähltechnologien. Wenn zwei Fußgänger nebeneinander vorbeifahren oder wenn eine Gruppe gleichzeitig das Erfassungsfeld überquert, hat der Sensor möglicherweise nur eine Person statt mehrerer. Dieses Phänomen, das als Okklusion oder Untererkennung bezeichnet wird, tritt besonders häufig zu Stoßzeiten, am Eingang von Sportanlagen oder auf Radwegen auf, die Fußgänger und Radfahrer miteinander verbinden.

Stereoskopische Wärmesensoren lösen dieses Problem teilweise dank ihres doppelten Erfassungswinkels, wodurch Personen in der Nähe besser voneinander getrennt werden können. Aber kein System beseitigt diese Verzerrung in einer Situation mit sehr dichter Strömung vollständig. Das Wichtigste ist, den Schwellenwert zu kennen, bei dem sich die Präzision verschlechtert, um die Interpretation der Daten entsprechend anpassen zu können.

Bei thermischen Sensoren können die Umgebungstemperatur und das Vorhandensein externer Wärmequellen zu Verzerrungen führen. Bei extremer Kälte ist der Temperaturunterschied zwischen dem menschlichen Körper und der Umgebung ausgeprägter, was die Erkennung verbessern kann. Umgekehrt verringert sich bei großer Hitze, insbesondere auf Oberflächen, die direktem Sonnenlicht ausgesetzt sind, der Wärmekontrast und der Sensor kann bestimmte Passagen übersehen oder Fehlalarme erzeugen.

Parasitäre Wärmequellen sind eine weitere Gefahr: geparkte Fahrzeuge, elektrische Geräte, Lüftungskanäle. Eine sorgfältige Analyse des Standorts vor der Installation ermöglicht es, diese Risiken zu identifizieren und die Positionierung des Sensors so anzupassen, dass sie minimiert werden.

Die Montagehöhe ist einer der Parameter, der von nicht spezialisierten Installateuren am häufigsten unterschätzt wird. Jede Technologie verfügt über einen optimalen Höhenbereich, der ein ausreichendes Erfassungsfeld im Verhältnis zur Breite des zu messenden Pfades gewährleistet. Wenn der Sensor zu niedrig ist, kann er Grenzpassagen übersehen oder Okklusionen erzeugen. Ist das Erfassungsfeld zu hoch, reicht das Erfassungsfeld über den Zielpfad hinaus und kann parasitäre Passagen erfassen.

Der Einbauwinkel, insbesondere die senkrechte Position des Sensors in Bezug auf den Fluss von Fußgängern oder Radfahrern, beeinflusst ebenfalls die Genauigkeit. Ein schlecht ausgerichteter Sensor kann Benutzer, die schräg vorbeifahren oder langsamer fahren, systematisch unterzählen.

Ein mit 25 km/h gestarteter Radfahrer überquert in Sekundenbruchteilen das Erfassungsfeld eines Sensors. Ein Kleinkind, ein Rollstuhlfahrer oder eine Gruppe langsamer Spaziergänger haben ganz andere Signaturen als ein Erwachsener, der in normalem Tempo geht. Die am wenigsten ausgeklügelten Sensoren, die auf ein einziges Benutzerprofil kalibriert sind, können bestimmte Profile unter- oder überzählen.

Die fortschrittlichsten Multi-Flow-Sensoren verfügen über eine Kategorisierungslogik, die Geschwindigkeit und thermische Signatur berücksichtigt, um Benutzertypen zu unterscheiden. Dies verbessert die Gesamtgenauigkeit und liefert gleichzeitig umfangreichere Daten für die Auswertung.

Die Antwort auf diese Frage hängt davon ab, wie Sie die Daten verwenden. Für eine wissenschaftliche Untersuchung der Strömungen in dicht besiedelten städtischen Gebieten kann eine Fehlerquote von 1 bis 2% erforderlich sein. Für eine Gemeinde, die die Nutzung einer Grünstraße verwalten, die Auswirkungen einer Entwicklung bewerten oder einen Bericht für einen öffentlichen Geldgeber erstellen möchte, ist eine Fehlerquote von 3 bis 5% durchaus akzeptabel.

Was für territoriale Nutzungen wichtiger ist, ist die Konsistenz und Stabilität der Fehlermarge im Zeitverlauf. Ein Sensor, der systematisch 3% unterschätzt, kann weiterhin verwendet werden, um Trends zu analysieren, Zeiträume zu vergleichen, Spitzenverkehrszeiten zu identifizieren oder die Entwicklung einer Achse vor und nach der Entwicklung zu messen. Wichtig ist, dass der Bias konstant und bekannt ist, und nicht, dass er gleich Null ist.

Fazit: Nicht die absolute Präzision zählt am meisten, sondern die Stabilität der Fehlerspanne im Zeitverlauf. Eine konstante und bekannte Verzerrung kann ausgenutzt werden; eine variable und unvorhersehbare Verzerrung beeinträchtigt die Vergleichbarkeit der Daten.

Umgekehrt erzeugt ein Sensor, dessen Genauigkeit je nach den Bedingungen stark schwankt (von 98% bei schönem Wetter bis zu 70% bei Regen), Daten, deren Vergleichbarkeit beeinträchtigt ist. Ein Bericht, der auf diesen Daten basiert, erlaubt es uns nicht, den Schluss zu ziehen, ob eine beobachtete Entwicklung real ist oder mit einem Messartefakt zusammenhängt.

Verschiedene Ansätze ermöglichen es, über die in den technischen Datenblättern angegebenen Präzisionszahlen hinauszugehen.

Fordern Sie Validierungsdaten unter realen Bedingungen an. Ein seriöser Hersteller muss in der Lage sein, die Ergebnisse von Vergleichstests, die an Referenzstandorten durchgeführt wurden, vorzulegen, wobei manuelle oder duale Zählungen durchgeführt werden, um die tatsächliche Genauigkeit zu überprüfen. Bei diesen Prüfungen müssen verschiedene Bedingungen berücksichtigt werden: dichte Strömung, schlechtes Wetter, Nacht, gemischte Profile.

Fragen Sie nach der Methode zur Berechnung der Genauigkeit. Wird die angekündigte Rate anhand einfacher Passagen oder anhand realer Ströme berechnet? Über welchen Zeitraum und auf welcher Art von Website? Diese Angaben ermöglichen es, die Abbildung in einen Kontext zu stellen.

Überprüfen Sie die Stabilität der Genauigkeit im Laufe der Zeit. Ein System, das sich ohne regelmäßige Neukalibrierung zunehmend verschlechtert, wirft ein Problem der Vergleichbarkeit der Daten über mehrere Jahre auf. Finden Sie heraus, wie oft Sie eine Wartung benötigen, um die garantierte Genauigkeit aufrechtzuerhalten.

Konsultieren Sie das Feedback ähnlicher Benutzer. Gemeinden oder Manager, die die Lösung bereits in ähnlichen Kontexten wie Ihrem eingesetzt haben, sind die besten Informationsquellen über das tatsächliche Verhalten des Sensors.

Die stereoskopischen Wärmesensoren der neuesten Generation, deren Design auf doppelter Erkennung und einem Algorithmus zur Strömungsklassifizierung basiert, erreichen unter normalen Einsatzbedingungen Genauigkeitsraten von 95 bis 98%. Diese Leistung wird unabhängig vom Umgebungslicht erreicht, was einen erheblichen Vorteil gegenüber Systemen darstellt, die auf Bildverarbeitungs- oder passiven Infrarotsensoren basieren.

Die verbleibende Fehlerquote ist hauptsächlich auf sehr dichte Ströme und strikt gleichzeitige Durchgänge zurückzuführen. Es ist im Laufe der Zeit homogen und bekannt, was es ermöglicht, es in Datenanalysemethoden zu integrieren. Für lokale Behörden und Gebietsverwalter ist diese Stabilität die Garantie dafür, dass Vergleiche von einem Jahr zum nächsten oder vor und nach einer Entwicklung die tatsächlichen Veränderungen der Besucherzahlen und nicht die Schwankungen der Sensorleistung widerspiegeln.

Genau diese Zuverlässigkeit im Laufe der Zeit macht das Zählen von Daten zu einem glaubwürdigen Instrument, um öffentliche Investitionen zu rechtfertigen, Zuschussanträge zu erstellen oder Mobilitätspolitiken zu bewerten.

Die Bewertung eines Geschwindigkeitsmessers ausschließlich anhand seiner theoretischen Genauigkeitsrate ist dasselbe wie die Auswahl eines Autos ausschließlich anhand seiner Höchstgeschwindigkeit. In einer realen Situation kommt es auf die Leistung unter normalen Betriebsbedingungen, die Konsistenz der Daten im Laufe der Zeit und die Fähigkeit des Systems an, verwertbare Informationen für die Entscheidungsfindung zu liefern.

Für Gemeinden, Tourismusbüros, Parkmanager oder Veranstalter Ein Sensor mit einer stabilen Genauigkeit von 96% ist besser als ein System mit einer Stabilität von 99% im Labor deren Leistung sich jedoch bei Regen, bei dichter Strömung oder nach einigen Monaten Betrieb ohne Wartung verschlechtert.

Vor jedem Kauf sind Validierungsdaten unter realen Bedingungen erforderlich, die Stabilität der Präzision im Laufe der Zeit in Frage zu stellen und die Zahlen mit den Rückmeldungen ähnlicher Benutzer zu vergleichen, um eine fundierte Entscheidung zu treffen.